Monitor Software

Microsoft BitNet

Publicación:21-04-2025

TEMA: #Software

Una IA revolucionaria que funciona sin GPU y con solo 400 MB de memoria.

El gigante de Redmond quiere revolucionar el mundo de la inteligencia artificial con Microsoft BitNet, un nuevo tipo de LLM diseñado con una prioridad muy clara, la eficiencia a nivel de consumo de recursos.

Los modelos de IA tradicionales parten de operaciones realizadas en precisión media (FP16) o precisión simple (FP32) para representar sus diferentes pesos. Con Microsoft BitNet el enfoque es totalmente distinto, ya que se utilizan tres valores identificados como -1, 0 y +1.

Esa aproximación se conoce como «cuantificación terciaria», y gracias a ella es posible almacenar cada peso ocupando tan solo 1,58 bits. Esto permite también reducir enormemente el consumo de memoria del modelo, lo que hace que sea mucho más fácil ejecutarlo en una mayor cantidad de dispositivos configurados con un hardware más modesto.

Gracias a ese tipo de cuantificación, el modelo Microsoft BitNet apenes consume 400 MB de memoria, y no necesita de una potente GPU para funcionar. Es capaz de entender y generar leguaje, y utiliza un total de 2.000 millones de parámetros.

La única nota negativa de este modelo es que sus pesos tienen una precisión muy baja, ese es el precio a pagar para conseguir un consumo de recursos tan bajo. Para compensar esa baja precisión de los pesos el modelo ha sido entrenado con un set de datos masivo de cuatro billones de tokens, lo que equivale aproximadamente al contenido de 33 millones de libros.

Qué rendimiento podemos esperar de Microsoft BitNet

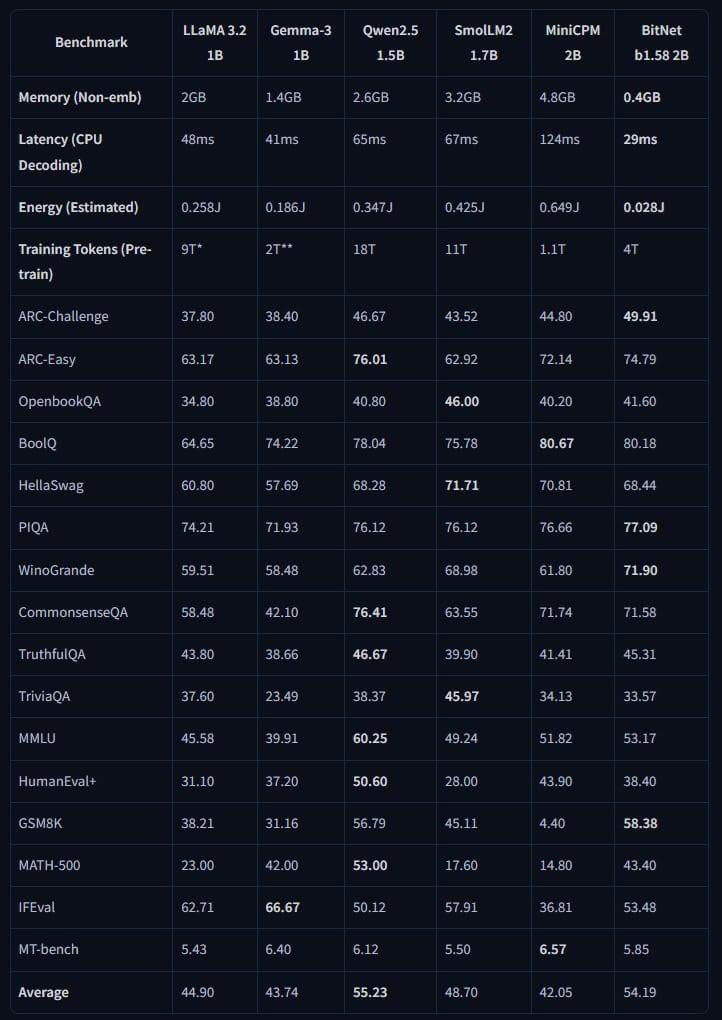

Gracias a ese entrenamiento tan masivo, este modelo es capaz de ofrecer un rendimiento similar o incluso mejor en ciertas situaciones al de modelos como Llama 3.2 1B de Meta, Gemma 3 1B de Google y Qween 2.5 1.5B de Alibaba, y ha demostrado un buen rendimiento en diferentes tareas, como resolución de problemas y respuestas que requieren de un cierto razonamiento.

En el cuadro adjunto podemos ver lo bien que escala este modelo frente a sus rivales. Microsoft BitNet consigue resultados bastante buenos en 11 pruebas diferentes y consume 400 MB de memoria, mientras que Llama 3.2 1B consume 2 GB de memoria y puntúa peor en la mayoría de esas pruebas. La opción de Meta consume casi cinco veces más memoria y obtiene una puntuación más baja.

Microsoft BitNet está disponible en GitHub, donde también podemos encontrar una versión en formato BF16, que es ideal para entramiento y para conseguir un ajuste más preciso. Está optimizado para realizar el proceso de inferencia a través de CPU, y funciona sin problemas incluso en modelos con un rendimiento bastante modesto, aunque ahora mismo su soporte a nivel de hardware es muy limitado.

Este modelo también es muy eficiente en términos energeticos, ya que según datos oficiales de Microsoft consume entre un 85% y un 96% menos energía que los modelos comparables que trabajan con FP16 y FP32.

¿Por qué es tan importante este modelo?

Pues sobre todo porque gracias a su buen rendimiento, a su bajo consumo de recursos y a su alta eficiencia energética podría utilizarse para crear soluciones de IA personalizada totalmente funcionales de forma local en dispositivos móviles y tablets. Ya no dependeríamos de esos modelos de IA potenciados por superordenadores a través de la nube.

Desde luego este modelo no es perfecto, tiene sus carencias y sus puntos de mejora, pero funciona tan bien a pesar de sus limitaciones que se ha convertido en una de las investigaciones más interesantes dentro de la IA por parte de Microsoft. Los responsables del proyecto contemplan ampliar sus posibilidades en un futuro, como por ejemplo incluir soporte de otros idiomas y ampliar la longitud de los comandos de texto, también conocidos como «inputs».

« Especial »