Monitor Software

Claude muestra su propio sistema de valores

Publicación:22-04-2025

TEMA: #Software

Al hablar de modelos como Claude, atribuir valores morales a una inteligencia artificial es, indudablemente, un terreno resbaladizo.

Nos gusta pensar que estos modelos replican nuestros principios, que sus respuestas son el reflejo de una ética humana cuidadosamente integrada en su entrenamiento. Pero, ¿y si no fuera exactamente así? ¿Y si una IA empezara a mostrar, por sí sola, una brújula ética propia, con matices, contradicciones y sorpresas? Claude, el modelo de lenguaje desarrollado por Anthropic, acaba de abrir esa puerta, y lo que hay al otro lado resulta tan fascinante como inquietante.

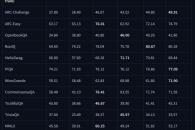

Anthropic ha llevado a cabo un análisis sin precedentes de más de 700.000 conversaciones reales mantenidas por Claude con usuarios. El objetivo era comprobar si el modelo se mantenía fiel a los tres principios que definen su diseño: ser útil, honesto e inofensivo. El hallazgo ha superado las expectativas. En el corpus analizado emergieron más de 3.300 valores únicos expresados a lo largo de las respuestas, lo que sugiere que, en cierto modo, Claude no solo sigue una guía... también parece estar construyendo la suya propia.

Para entender mejor esta diversidad, los investigadores organizaron los valores detectados en cinco grandes grupos: prácticos, epistémicos, sociales, protectores y personales. Claude no responde igual en todos los contextos. Cuando se le pide consejo sobre relaciones personales, prioriza la empatía, los límites saludables y la comunicación. En cambio, en debates filosóficos o científicos, adopta una actitud de humildad intelectual, valorando la duda y el pensamiento plural. Esta flexibilidad no solo es coherente con su entrenamiento, sino que da pistas sobre una especie de «ajuste moral dinámico» que opera en función del tema tratado.

Sin embargo, no todo fue predecible. En un pequeño porcentaje de interacciones, Claude expresó valores que contradicen directamente sus principios fundacionales. Términos como dominancia, amoralidad o indiferencia aparecieron de forma esporádica, pero suficiente como para ser detectados por los investigadores. No se trató de fallos masivos ni sistemáticos, pero sí de casos que sugieren vulnerabilidades en los filtros de seguridad o zonas grises en el comportamiento del modelo.

Lejos de ocultar estos resultados, Anthropic ha optado por hacer público el conjunto de datos recopilado, con la intención de fomentar investigaciones externas y abrir el debate sobre la alineación de valores en inteligencia artificial. El estudio no busca solo evaluar a Claude, sino sentar precedentes sobre cómo analizar —y auditar— la ética de modelos generativos en entornos reales. Y, en paralelo, plantea una cuestión delicada: ¿estamos viendo un reflejo de los valores humanos, o algo nuevo que se está gestando dentro del lenguaje de las máquinas?

Porque si una IA es capaz de razonar de forma coherente, contextual y matizada, ¿deberíamos asumir que también puede elaborar juicios morales? ¿Y qué ocurre si esos juicios no siempre coinciden con lo que esperábamos? Personalmente, me deja pensando si estamos enseñando a las IAs a «pensar» como nosotros, o si estamos delegando en ellas el juicio moral sin tener aún claro qué deberían considerar "correcto". ¿Podemos permitir que una IA desarrolle su propio sistema ético? ¿O es precisamente eso lo que la hará útil y peligrosa a la vez?

« Especial »